データ分析において、データの準備は大変重要なステップです。こういった多大な知識を必要とするような話題を一つの記事だけで取り上げること自体が難しいかもしれませんが、ここでは分析用データを用意する際に確認すべきチェックリストを紹介していこうと思います。読者の皆様がデータを準備する際の助けになれば幸いです。

データの準備プロセスとは?

アバディーングループ(米国の大手金融企業)のレポートによれば、データの準備とは、「データの質、有用性、可用性、可搬性などを向上させるために行うものであるが、いずれの場合においても、その最終的な目標は、分析者やシステムがクリーンなデータを使い有効な洞察を得ることである。」とされています。この最終的な目標の部分についてはデータの準備だけではなく、データの統合、認証、整理、ガバナンスにも等しくあてはまります。

まず始める前に:ビジネス課題を特定しよう

一般論としても言えることですが、どのようなデータ分析であっても、ビジネス上の課題に対する解決策や、推し量りたいKPIを知りたいという目的からスタートします。

ビジネス上の要求をきちんと理解していれば、その後に行う分析に要点をしっかりと盛り込むことができますし、一方でその理解が不十分であれば、後になって労力や時間を多大に浪費してしまう可能性があります。そのため、このステップは飛ばさずしっかりと行いましょう。

分析に反映させるべきビジネス要求を把握すると、データを使い分析したいものが見えてくるでしょう。まずはそれを見つけてみましょう。

どこにデータがあるか?

まず始めに確認すべき点は、使用したいデータが物理的に組織のどこに存在するのかということです。規模が小さい組織であればスプレッドシートのようなシンプルな形で入手できるかもしれませんが、大規模な組織となると複数のデータベースやハドゥープデータレイク、その他データソースとなりうるデータウェアハウスを見る必要があるかもしれません。

また、使用したいデータに対するアクセス権限があるか否かといった点や、どのような型・フォーマットでそのデータを扱うのかも確認しておく必要があるでしょう。

ここでは以下の点を確認しましょう:

- 組織でどのようなデータソースを使っているのか

- データのアクセス権限や裁量を持っているか

- それぞれのデータセットのサイズや、それぞれどのくらいのデータを得る必要があるのか

- それぞれのデータベースにあるスキーマやテーブルに対して自分がどれほど知っているか

- 細かい粒度で分析するための全データが必要なのか、パフォーマンス速度を重視して部分的なデータのみを取得するのか

- 相違のあるデータを標準化する必要があるか(例:SQLデータベースとMongoDBのデータを組み合わせる場合など)

- 組織内に保管されていないような外部のデータを分析する必要があるか?

データを改変する必要があるか?

有効な分析のために、データを手作業で変換しなければならないことはよくあります。例えば、複数のテーブルやデータセットで同じ情報が異なったフォーマットで扱われている場合や、一貫性のないデータや重複があるデータ、あるいは新たな軸でデータをまとめたいときなどは変換の必要性があるでしょう。

ここでは以下の点を確認しましょう:

- それぞれのデータソースについて、そのデータは完全なものか?正確か?最新化されているか?

- 現時点で、このデータは自分のビジネス課題に対する答えとなりうるか

- もし矛盾した値がある場合にどのようにクレンジングするか。クレンジングが必要なデータ量をみて、それは手作業で行うべきなのか、それともシステムを構築すべきなのか

- データの発掘や処理を速くするため、生データの保管先に直接ツールを繋ぐのか。元データを変える場合、直接行うことができるのか別環境を挟む必要があるのか(例: 製品データを改変する権限がない場合など)

どのようにデータにアクセスするか

もし複数の異なるデータソースやテーブルを跨いで分析を行う場合、ダッシュボードユーザーがその場で出したクエリに対して、すぐさま複数テーブルのカラムを繋ぎ合わせて答えを導けるようにデータモデルを定めておく必要があります。作成したデータモデル内にある様々なデータソースの関係性が、将来的にデータ分析をした際の答えを導くクエリの形と効率を決めます。

ここでは以下の点を確認しましょう:

- カラム同士をつなぎ合わせたとき、データ同士がどのような関係性になるか。多対多(n*n)の関係性は避けたい。

- 将来的に拡張可能なデータモデルか?

- 将来的にモデルに追加や改変を加える際、どれほどの労力がかかりそうか

- パフォーマンスに影響させずにどこまで関係性をシンプルにできるか。(これは使用しているデータや分析ツールによって異なります。)

追加で統合するデータはあるか?

複雑な分析になってくると、最初に作ったものに追加して新たなテーブルを作成したくなるかもしれません。一つの例として、ファネル分析の際にそれぞれのステージでより分けられるレコードに対してカテゴリ分けを行いたい場合などが挙げられます。

こういった際にテーブルを追加すべきか否かを判断するポイントとして以下を例に挙げましょう:

- 分析結果をまとめるサマリテーブルが必要か

- 現在扱っているデータに対して内部・外部結合をしてデータを統合すべきか、あるいは新たなテーブルを作成するか

どのようにデータをインポートするか

データ分析レポート作成をする際に、データベース製品に対してクエリを発行することはよくあります。ほとんど全てのBIツールで、分析データベースとは別の環境でデータを整理してから分析用のワークスペースにそれを移動するでしょう。

ここでは以下の点を確認しましょう:

- データを移動したいローカル・クラウド環境に、扱いたいデータ量をさばけるだけの十分なソフト・ハードウェア環境があるか。(ソフトとハードは幾分独立している面もありますが、正しいソフトウェアを使うことでハードウェアのコストを圧縮することができます。)

- どのくらいの頻度でデータをインポートする必要があるか。これは元データのみを使って分析する割合によって異なる。

- データのインポートが分析環境に与える影響はどのくらいか

分析結果をどのように検証するか?

データ分析が完了した報告をする前に、分析結果が誤りなく正確なものであるか否かを確認したくなるのは当然でしょう。

結果を検証するために、以下の点を確認しましょう:

- 普通に見て理解できる内容か

- 分析結果が、自分が知っている事実と一致するか

- 分析環境で導き出した答えが、同じ計算手順で元データを手計算した結果に一致するか

分析を始めよう!

上記のチェックリストを全て確認したら、使うべきデータを特定、改変し、データモデルを決定し、分析環境にデータを移動させた上で、検証された結果を導き出せていることでしょう。これには数時間~数日、あるいはそれ以上の時間がかかるでしょう。どれほどかかるかは扱うデータの量や分析の複雑性によって異なります。

もし全て上手くいったなら、ダッシュボードの作成にとりかかりましょう!ダッシュボードを作成する際には、我々のダッシュボードデザインガイドを見て、わかりやすくデータ分析の内容を理解させる原則を学びながら作成してみてください。

この投稿に記載されているすべてのデータは情報提供のみを目的としており、正確ではありません。

本記事は、Sisense社の許諾のもと弊社独自で記事化しました。

https://www.sisense.com/blog/6-questions-to-ask-when-preparing-data-analysis/

※ Sisense は、Sisense Inc の商標または登録商標です。

※ その他の会社名、製品名は各社の登録商標または商標です。

※ 記事の内容は記事公開時点での情報です。閲覧頂いた時点では異なる可能性がございます。

キーワード

注目の記事一覧

-

経営者の『勘』を『確信』へ。AIとの対話が生む、インサイト血肉化の全貌

経営者の『勘』を『確信』へ。AIとの対話が生む、インサイト血肉化の全貌

-

AIガバナンスとデータ主権。2026年に備えるべきSAP環境でのデータ戦略

AIガバナンスとデータ主権。2026年に備えるべきSAP環境でのデータ戦略

-

「組み込み分析」導入の手引き:CTO・担当者が押さえるべきポイントとは

「組み込み分析」導入の手引き:CTO・担当者が押さえるべきポイントとは

-

データドリブン経営の成功へ導く!主要ABIプラットフォーム徹底比較

データドリブン経営の成功へ導く!主要ABIプラットフォーム徹底比較

-

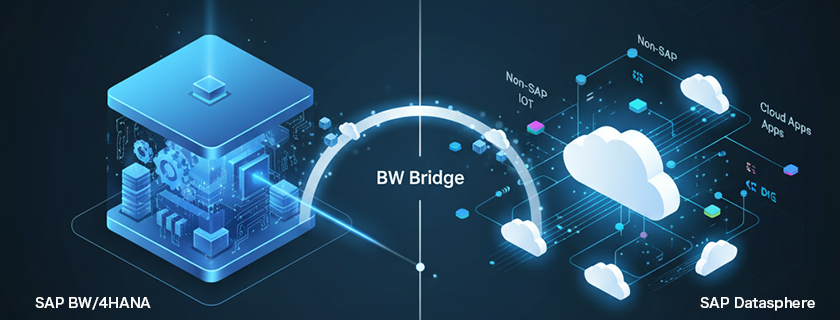

「BWの未来」と「Datasphereの真価」:SAP導入企業が取るべき次の一手

「BWの未来」と「Datasphereの真価」:SAP導入企業が取るべき次の一手

月別記事一覧

- 2026年1月 (1)

- 2025年12月 (1)

- 2025年11月 (2)

- 2025年10月 (2)

- 2025年9月 (2)

- 2025年8月 (1)

- 2025年7月 (2)

- 2025年6月 (1)

- 2025年5月 (2)

- 2025年4月 (2)

- 2025年3月 (1)

- 2025年2月 (1)