Sisense社では、顧客のさまざまなユースケースやデータソースを解析することで、顧客の要望と使用パターンに基づいた、データベース市場の動向を分析しております。現在データベース市場のトレンドとして、Amazon S3、 Snowflake、Google BigQueryなどクラウドベースのデータレイクが急成長していることがあげられます。

過去の四半期だけでも、顧客のクラウドデータレイクへの接続が倍増し、情報源によっては3倍にまで膨れ上がったものもあります。クラウド分析データベースであるAmazon Redshiftの成長率は20%だったのに対してどうでしょうか。

データレイクとは大部分のデータを蓄積するための場所であり、通常は一部が構造化、もしくは非構造化の形式となっています。現代のクラウドデータレイクが他と差別化を図っている重要なポイントは以下の通りです。

- ストレージとコンピューターのためのインフラストラクチャーとコストの分離

- 任意のデータ型の格納

- インフラストラクチャーの抽象化

- 無限のスケーラビリティ

これらの技術の成長の要因は、ビッグデータ、使いやすさや、柔軟な価格設定、質の高いサービスの提供などがあげられます。

「データレイク」の成長を促す要因とは

ビッグデータは現実的かつ民主化されている

クラウドは多くのデータを作成し、かつそれを分析するために必要なものです。過去10年を振り返ると、世界有数の大企業のみが分析に足る十分なデータを持っていました。そして、そのような大企業がHadoopなどの技術を導入するためには、必要な人件費やインフラストラクチャーに膨大なコストがかかりました。これらの複雑なシステムの導入や管理を支援するために、多くのサービスプロバイダーが立ち上げられましたが、必要な投資と人材を集めることは非常に困難なものでした。

今日では小規模企業は、クラウドで生成されたwebトラフィックやユーザーデータからペタバイトほどの情報を生成しているという例も少なくありません。中規模ビジネスで販売されているクラウド製品のユーザーデータは、一日のうちに数千万を超えるレコードが生成されており、追跡されたイベントの粒度によってのみスコープされています。これらの中規模ビジネスを行っている企業は、そのデータの価値を理解しており、そして手ごろな価格の取得方法を必要とし、また拡張性の高い価格設定モデルを使用して、より簡単なツールへの需要を生み出しています。

クラウドは管理を容易にする

「データレイク」はHadoopとほとんど同じ意味をなしています。Hadoopはオープンソースですが、必要なインフラストラクチャー、開発者、コンサルタント、セットアップ、保守などを鑑みて、完全に導入した場合、数百万ドルのプロジェクトになる可能性があります。

ここ数年では、新たなクラウドオプションがオンラインになり、インフラストラクチャープロバイダーによりメンテナンスの負担が軽減されることで、中小企業にとってはより手頃な価格となっております。Amazon S3は多種多様なストレージ用途に活用されていますが、管理が容易で新しいSQLインターフェイスがあるため、分析のためのデータレイクとして使用されています。S3には何かを保存することができ、AWSは自動スケーリング、暗号化、その他多くのユーティリティを処理することができます。

アジャイル開発に適した価格設定

クラウドデータレイクにはビジネスを安く開始するための価格モデルがあります。多額な先行投資の必要性をなくすために、クエリごとの価格設定も多数用意されています。S3データのクエリに使用されるAmazon AthenaとSpectrumは、スキャンした1TB当たりが5ドルのコストと、安価で開始することができます。

また、コストという観点で見ると、「ストレージとコンピューティングの分離」は、よりアジャイル開発に適しています。データストレージが非常に安く、ほとんどのコストがクエリからきています。したがって、必要と思われるデータを収集するための雛形を最初に構築し、その後で、臨機応変に本当に必要なものかどうかを判断して取捨選択を行うといった方法は、企業にとって理にかなった方法であるといえます。

この方法と現行を比較して、どちらを利用して前もってデータを収集するのかを選択しなければなりません。アナリストは数時間もしくは数分で、過去に収集したデータにクエリを実行することができます。一方で、データ収集フローを調整するとなると、複数のソリューションとエンジニアリングリソースを必要とするため非常に長いプロセスになります。

このモデルの欠点は、サーバーレスコンピューティングと同様に、アドホッククエリが永続的なタスクに移行する際に、ユーザーがコストコントロールについて考える必要があることです。

多くのアクセシビリティとその選択

過去二年間で、分析アプリケーションとうまく連携するSQLツールを利用して、S3のようなデータレイクを参照する新たな方法が登場しました。

それは以下のようなものです。

- AthenaやSpectrumなどのAWS製品

- Apache Drill、Presto、Hiveなどのオープンソースツール

- スノーフレークやBigQueryのような、ネイティブのコンピューティングレイヤーを備えた統合ソリューション

このような非常に多くの標準SQLソリューションが登場することで、ユーザーは、管理の容易さやパフォーマンス、拡張性、そしてコストを考慮して最適なものを選択することができるようになります。

しかしながら、企業は、ソリューションを選択するときにこれらの兼ね合いを考慮して選択する必要が出てきたことにも注意する必要があります。

今、クラウドデータ市場全体が成長する一方で、分析などのユースケースでは、クラウドデータレイクがリレーショナルデータベースから市場シェアの大部分を占めると予想されています。

そして、需要が多様化・高度化することで、チームがさまざまな製品を考慮し、それぞれの特徴を最大限に生かしながら、データパイプラインを強化する必要が出てきます。特定のデータフローでは、すべてのレコードを高速で検索するためにリレーショナルデータベースもしくはタプルベースのデータベースが必要になります。その他のデータフローでは、一括分析クエリ用のカラム型データベースエンジンが必要になります。これは、相互運用可能で幅広いツールを利用できるようなインフラストラクチャープロバイダーを利用してクラウドを開始することにより企業は高い価値を得ることができると私たちは考えています。

この投稿に記載されているすべてのデータは情報提供のみを目的としており、正確ではありません。

本記事は、Sisense社の許諾のもと弊社独自で記事化しました。

https://www.sisense.com/blog/4-trends-driving-growth-cloud-data-lakes/

※ Sisense は、Sisense Inc の商標または登録商標です。

※ その他の会社名、製品名は各社の登録商標または商標です。

※ 記事の内容は記事公開時点での情報です。閲覧頂いた時点では異なる可能性がございます。

キーワード

注目の記事一覧

-

経営者の『勘』を『確信』へ。AIとの対話が生む、インサイト血肉化の全貌

経営者の『勘』を『確信』へ。AIとの対話が生む、インサイト血肉化の全貌

-

AIガバナンスとデータ主権。2026年に備えるべきSAP環境でのデータ戦略

AIガバナンスとデータ主権。2026年に備えるべきSAP環境でのデータ戦略

-

「組み込み分析」導入の手引き:CTO・担当者が押さえるべきポイントとは

「組み込み分析」導入の手引き:CTO・担当者が押さえるべきポイントとは

-

データドリブン経営の成功へ導く!主要ABIプラットフォーム徹底比較

データドリブン経営の成功へ導く!主要ABIプラットフォーム徹底比較

-

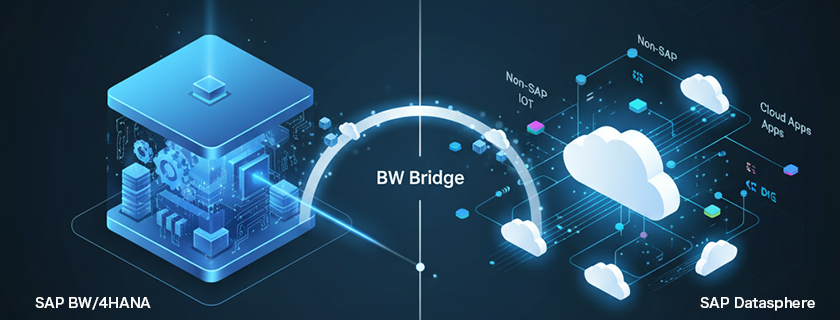

「BWの未来」と「Datasphereの真価」:SAP導入企業が取るべき次の一手

「BWの未来」と「Datasphereの真価」:SAP導入企業が取るべき次の一手

月別記事一覧

- 2026年1月 (1)

- 2025年12月 (1)

- 2025年11月 (2)

- 2025年10月 (2)

- 2025年9月 (2)

- 2025年8月 (1)

- 2025年7月 (2)

- 2025年6月 (1)

- 2025年5月 (2)

- 2025年4月 (2)

- 2025年3月 (1)

- 2025年2月 (1)